Au Nigeria, les deepfakes se multiplient : journalistes, médecins ou banquiers sont imités par l’IA pour escroquer ou manipuler. De simples outils numériques alimentent une fraude massive qui brouille la frontière entre vérité et illusion.

Au Nigeria, l’intelligence artificielle est devenue une arme de fraude massive. Depuis 2023, les fact-checkers et journalistes nigérians documentent une série de vidéos et publicités manipulées, générées avec des outils d’IA, qui exploitent l’image de personnalités respectées pour vendre des mirages financiers ou médicaux.

En novembre 2023, une vidéo truquée circule sur les réseaux : on y voit Kayode Okikiolu, présentateur de la chaîne Channels Television, expliquer qu’un médecin aurait découvert un remède « définitif » contre l’hypertension. Le décor est réaliste, la voix semble authentique, le ton est familier.

Des faux médecins et banquiers fabriqués par algorithme

Sauf que tout est faux : l’image a été modifiée par IA, la bande-son est un clonage vocal, et le journaliste n’a jamais prononcé ces mots. Des enquêtes de médias nigérians et d’ONG de fact-checking démontrent que la vidéo sert à promouvoir des produits douteux, hors de tout circuit médical.

Quelques mois plus tard, une autre séquence met en scène l’ancien ministre de la Santé, Osagie Ehanire, présenté comme invité d’une émission d’Arise TV. Il y vante lui aussi une cure miracle contre l’hypertension, affirmant même avoir été limogé pour avoir osé la révéler. Là encore, les analyses confirment que l’entretien n’a jamais existé : images recomposées, voix synthétique, montage manipulé pour coller au format d’une interview télévisée.

Les fraudeurs ne se contentent pas de la santé. Des personnalités économiques comme Tony Elumelu, figure incontournable du secteur bancaire et de l’entrepreneuriat africain, sont régulièrement utilisées dans des deepfakes pour légitimer de faux programmes d’investissement ou des crypto-projets frauduleux. Des vidéos circulant sur Instagram et Facebook le montrent prétendument recommander des plateformes promettant des rendements extravagants aux épargnants nigérians – alors qu’il s’agit de montages générés par IA.

Dans tous ces cas, la mécanique est la même : l’IA sert à imiter le visage et la voix d’une figure crédible, pour vendre un produit miracle ou un placement. La force de l’arnaque repose sur la confiance préexistante dans le personnage public et sur la difficulté, pour un internaute lambda, de détecter les artefacts subtils des deepfakes.

Quand les deepfakes s’invitent dans la présidentielle de 2023

Ce même arsenal technologique a aussi touché le cœur de la vie politique nigériane. Lors des élections générales de 2023, plusieurs études universitaires et organisations spécialisées en cybersécurité décrivent une campagne électorale marquée par l’usage combiné de désinformation classique et de contenus générés par IA.

Selon ces travaux, les réseaux sociaux nigérians, Twitter/X, Facebook, TikTok, WhatsApp, ont été saturés de montages vidéo et audio attribuant à des candidats des déclarations qu’ils n’avaient jamais faites. L’objectif : les présenter comme violents, sectaires ou corrompus, ou au contraire fabriquer des messages flatteurs pour leurs partisans. Les deepfakes n’étaient pas toujours techniquement parfaits, mais suffisamment convaincants pour un public déjà exposé à des années de rumeurs et de fake news.

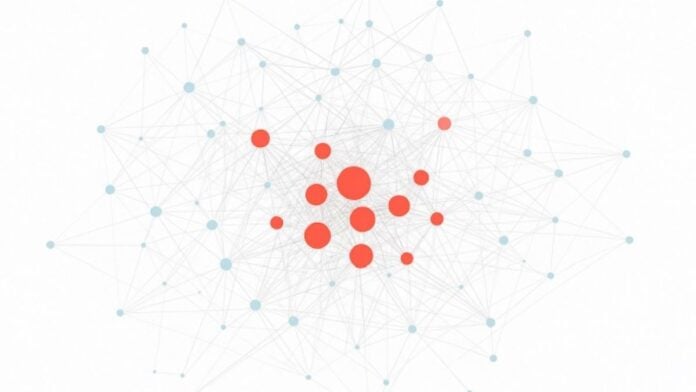

Des chercheurs cités par la London School of Economics décrivent une « inondation coordonnée » de contenus manipulés, renforcée par des armées de comptes organisés et de micro-influenceurs payés pour imposer certains narratifs et hashtags. Résultat : un climat de suspicion généralisée vis-à-vis de la commission électorale, des médias professionnels et même des résultats officiels.

Au-delà des cas précis, la présidentielle de 2023 illustre un basculement : le Nigeria est devenu un terrain où la frontière entre ce qui est réellement dit et ce qui est fabriqué s’estompe, à la faveur d’outils de plus en plus accessibles. Une étude publiée en 2025 insiste sur le double visage de l’IA : d’un côté, un potentiel pour aider à détecter et contrer la désinformation ; de l’autre, une capacité à produire à l’infini des contenus trompeurs, à très bas coût, pour peser sur les élections.

Fact-checkers débordés, régulateurs en retard

Face à cette vague de contenus synthétiques, les premiers remparts sont les rédactions et les organisations de fact-checking nigérianes, qui ont vu exploser le nombre de signalements liés aux deepfakes depuis 2023. Une recherche publiée en 2024 souligne que ces équipes, souvent sous-dotées, peinent à suivre le rythme, surtout lorsque les manipulations portent sur des images et des voix plutôt que sur des simples textes.

Plusieurs défis sont identifiés : manque d’outils techniques spécialisés pour analyser les traces de génération IA, absence d’accès direct aux données brutes des plateformes, et pression temporelle, un fact-check qui arrive trois jours après la diffusion virale d’un deepfake corrige l’histoire, mais trop tard pour empêcher l’effet politique ou financier.

Du côté des institutions, la réponse commence tout juste à se structurer. En 2025, la commission électorale nigériane (INEC) a annoncé la création d’une division dédiée à l’intelligence artificielle, chargée à la fois d’améliorer la gestion des élections et de combattre la désinformation numérique. Mais les juristes soulignent que la législation existante, Electoral Act 2022, loi sur la cybercriminalité, a été pensée pour les rumeurs et discours de haine « classiques », et non pour des contenus synthétiques capables de tromper même des observateurs avertis.

Des organisations de la société civile appellent à des règles plus claires : obligation de signaler l’usage d’IA dans les contenus de campagne, sanctions spécifiques pour la fabrication de deepfakes visant à influencer le vote, et coopération renforcée avec les géants du numérique pour détecter en amont les vidéos manipulées.

Un laboratoire africain des dérives de l’IA

Pris ensemble, les deux fronts, arnaques financières et sanitaires d’un côté, manipulation électorale de l’autre, font du Nigeria un véritable laboratoire africain des usages dévoyés de l’intelligence artificielle.

Le pays cumule plusieurs facteurs de vulnérabilité : une population jeune et hyper-connectée, une confiance parfois fragile envers les institutions, une forte polarisation politique, et une régulation du numérique encore en construction. Dans ce contexte, l’IA agit comme un multiplicateur : elle industrialise des pratiques anciennes (escroqueries, rumeurs, propagande) en les rendant plus crédibles, plus rapides et plus difficiles à débusquer.

Pour autant, le Nigeria n’est pas condamné à subir. Les mêmes technologies peuvent servir à détecter les deepfakes, à assister les fact-checkers, à cartographier les campagnes de désinformation et à développer des programmes d’éducation aux médias adaptés aux réalités locales. Plusieurs projets de start-up, d’universités et de consortiums de journalistes travaillent déjà sur des outils de détection et de veille appliqués aux voix, aux langues et aux contextes nigérians.

La question, désormais, est moins de savoir si l’IA va transformer la vie publique nigériane que de déterminer qui contrôlera ces outils et dans quel cadre.